Voir & savoir

une relation ambiguë

Francis Edeline

Index

Mots-clés : catégorie, hiérarchie, perception, psychologie de la forme, schème, sensation

Auteurs cités : Gérard Chazal, Claus Emmeche, Martin HEIDEGGER, Julian Hochberg, Jesper Hoffmeyer, Bärbel Inhelder, Emmanuel KANT, Jean-Luc Nancy, Jean PETITOT, Jean Piaget, René THOM

La relation entre Voir et Savoir, ou plus généralement entre percevoir et savoir, est à la base de plusieurs disciplines: la psychologie, l’épistémologie, la sémiotique cognitive et la philosophie, notamment. Je voudrais l’aborder à sa racine même, en essayant d’indiquer quelle contribution la sémiotique, collant de près aux découvertes encore chaudes de la neurophysiologie, peut apporter au débat. La délimitation du concept de savoir est claire, même s’il n'est pas aisé d’en saisir le contenu. C’est en tout cas un état mental. Par contre délimiter la vision pose déjà de sérieux problèmes car elle est psycho-physique : profondément immergée dans la perception et dans le mental à la fois. L’interface entre ces deux domaines, la transduction des données du premier vers le second, fait aujourd’hui l’objet de recherches acharnées. Ces données subissent-elles des transformations significatives en cours de route ? D’où découle une seconde question : l’aboutissement mental du processus de vision (ainsi d'ailleurs que celui de toute autre chaîne sensorielle) peut-il être automatiquement qualifié de savoir ?

- Note de bas de page 1 :

-

A ce propos consulter par exemple Hochberg (1995).

Il importe en somme de sortir du dilemme qu’offrent les deux opinions courantes: « on ne voit que ce qu'on sait déjà » et « n'est savoir que ce qui est validé par la vision ». Certes le sens de la vue joue un rôle dominant dans l’acquisition du savoir, mais c’est pour une raison circonstancielle et qui ne tient nullement à quelque vertu spécifique de la vision. D’ailleurs, au contraire, le savoir doit être défini comme amodal, c’est-à-dire au-dessus de toute modalité sensorielle. La perception visuelle néanmoins nous introduit facilement et automatiquement à la catégorisation et à la hiérarchisation des catégories, qui sont une des structures de base du savoir organisé. Mais tout ce que je vais dire pourrait aussi bien s’appliquer à un autre sens que la vue. Dernière précaution: il importe de ne pas confondre ce problème avec celui de la représentation, et encore moins avec celui de la reconnaissance d'objets 3D à partir d'images 2D1.

Kant et Heidegger aujourd'hui

Ce n’est évidemment pas une question nouvelle, elle a été mille fois posée, et depuis longtemps, mais il me semble que nous disposons aujourd’hui d’éléments nouveaux pour y répondre, éléments que ne pouvait utiliser un Kant par exemple. Kant, condamné à la simple introspection spéculative, ne pouvait qu'apercevoir clairement le problème et le poser, à partir justement de l’image visuelle.

Pour Kant l'image construit et produit son objet, et de ce fait engendre un savoir. L’imagination, faculté par laquelle l’homme produit des images, s'exerce sur « la dispersion confuse et incessamment dissoute du donné visuel », comme l’exprime très joliment J.-L. Nancy (2003). Il ne s'agit plus de « représenter » le donné sensible, mais de le soumettre à un « schème ». C'est donc une théorie de l’image comme mise en ordre signifiante du donné sensible. Le donné sensible brut, chaotique, n'a pas de sens: il n’en acquiert un que dans l’image, qui par le schème lui confère son unité et le transforme en totalité signifiante. Mais lorsque Kant se demande d’où vient le schème il ne peut que répondre: « c'est un secret impénétrable ».

Heidegger, qui a repris et développé cette théorie de Kant, ne semble pas apporter non plus d’éclaircissement à cette notion de schème, sinon qu’il estime qu'à son intervention quelque chose de vrai pourrait se dévoiler dans l'image. Nancy, qui évalue de façon critique ces deux approches, prend position fermement : « l'image...engage...une pensée de la clarté et de la distinction ». Le schème serait ainsi le « côté concept » de la représentation en général. Malheureusement il prend aussitôt des précautions qui rendent inopérante sa position. Pour lui l’image est certes transformée en unité (au sens fort) signifiante, mais il ne s’agit pas d’une unité qui lui serait surimposée, plaquée de force en quelque sorte. « Il ne s'agit pas d'arraisonner la grâce du flux sensible », de le figer, de le pétrifier en « objet géométrique ». L'unité en question est pour lui « l’unité du concept et du chaos plasmatique de la sensation ». Formule parfaitement incompréhensible et qui nous ramène au secret inviolable de Kant.

Par crainte de réductivisme, bien des sémioticiens actuels continuent, explicitement ou implicitement, à se fonder sur une telle conception.

Introspection vs expérimentation

On ne s'étonnera pas que l'introspection, bien mal adaptée pour un tel problème, soit incapable de proposer une solution. Il convient plutôt de se tourner vers les expérimentateurs, ceux qui font des tests, comparent les comportements de nombreux sujets et formulent des hypothèses vérifiables. Deux groupes ont choisi la méthode expérimentale: la psychologie de la forme (et sa descendance actuelle) et la psychologie génétique de Piaget et son école. Piaget est sans doute celui qui a poussé le plus loin la réflexion épistémologique à partir d’expériences et d’observations sur des enfants.

- Note de bas de page 2 :

-

Je conserve ici la terminologie qui est la sienne.

- Note de bas de page 3 :

-

Idem.

On connaît la farouche opposition de Piaget à ce qu’il appelait « Le mythe de l'origine sensorielle des connaissances scientifiques ». Ce texte important, publié en 1957, est toujours une pièce essentielle de sa théorie épistémologique dans la somme de 1970. Pour Piaget les sensations sont seulement des signaux, des indices2, qui déclenchent l’activité des sujets. Des ensembles d’actions, de mieux en mieux coordonnées, vont devenir des opérations, réelles ou virtuelles (c.à.d. intériorisées) et seront à l'origine des notions d’objet. Rien de tout cela n’est inné, tout doit être acquis par l’action. Le bébé doit apprendre à manipuler son biberon pour le sucer du bon côté. Plus tard l’enfant apprendra à coordonner ses manipulations de jetons interchangeables et atteindra les notions de classe et de nombre. Enfin par le jeu des assimilations et accommodations successives les schèmes3, les structures coordonnées en question, présenteront un accord de plus en plus satisfaisant avec les sensations enregistrées à partir du monde extérieur. Les schèmes, une fois acquis et stabilisés, serviront pour la connaissance future.

Pour Piaget donc, ni la sensation (réaction du corps aux stimulations extérieures ; elle porte sur des qualités : impression de couleur, de poids, d'odeur, de mouvement...) ni la perception (une synthèse secondaire de ces éléments, censée porter sur des objets, par exemple une feuille de papier) n’ont de rôle à jouer dans les processus mentaux qui se déroulent à partir d'elles et qui aboutissent à des connaissances.

Une question importante porte alors sur la nature, innée ou acquise, des structures mentales. L’école de Piaget, tout en se montrant réservée, voire hostile, quant à l’existence de structures innées, ne se prononce pas sur la capacité du cerveau à former et à héberger de façon durable des structures qui sont si efficaces pour assurer notre prise sur les choses. Elle ne se prononce pas vraiment non plus sur cette efficacité : est-elle posée seulement comme possible et susceptible d'être approchée par le jeu des accommodations, ou au contraire est-elle, par hypothèse ou par principe, envisagée comme totale et parfaite ? Cette deuxième éventualité serait un postulat très fort, impliquant que la forme (que Piaget conçoit comme « une imitation intériorisée » « d'actions réelles ou virtuelles ») est aussi dans les choses et que nous ne faisons que l’y retrouver par tâtonnement : ce serait une forme de réalisme. En effet dans un autre travail devenu classique, Piaget et Inhelder (1948) estiment que ce mécanisme mène automatiquement à un accord intersubjectif, que la méthode introspective ne pouvait évidemment expliquer. Faudrait-il en conclure que la lecture imagée adéquate du monde est unique et donc partagée par tous ? Nous pensons que non, puisque par exemple plusieurs peintres placés devant le même motif aboutiront à des « lectures » différentes.

Mais Piaget raisonne comme si ces structures d’ensemble, qui ne sont autres que le schème recherché, étaient comme déposées d'avance dans les potentialités du cerveau mais devaient parfois être réajustées sur le donné sensoriel. Il forge pour cela le célèbre schéma (empirique) d’ assimilation/accommodation : il y a alternance entre les phases où le donné sensoriel est soumis (au besoin en lui faisant violence) aux structures et celles où ces structures sont obligées de se modifier pour mieux s'adapter aux données des sens. Ou, pour revenir à mon point de départ, les phases où « on ne voit que ce qu'on sait déjà » et celles où « le savoir est validé par la vision ».

Piaget et son école postulent donc le réalisme des formes ainsi que la possibilité de les atteindre par tâtonnement plutôt que par une saisie directe. Or des tâtonnements n’offrent qu’une garantie pragmatique, ils n’ont théoriquement pas de fin et restent provoqués par un écart avec les données des sens, écart-moteur qui peut se réduire mais non s’annuler. Le problème est certes mieux posé, il est recentré mais mon résolu.

La théorie de la résonance

Le problème revient à répondre à la question telle que la pose Jean Petitot (1992) : « Comment la cohérence d'un flux de vécus esthésiques concordants peut-elle être équivalente à un objet transcendant ? » Mais la question ainsi posée est déjà problématique dans sa première partie, car comment savons-nous qu'un flux de vécus est cohérent ou concordant ? Avoir saisi cette cohérence, c'est avoir déjà résolu le problème de l'unité mentionné plus haut.

- Note de bas de page 4 :

-

On ne peut s'empêcher de rapprocher les 10 catégories d'Aristote et les 12 de Kant des 7 catastrophes élémentaires relevées par Thom. Si elles diffèrent profondément dans leur essence, elles n'en témoignent pas moins de la même démarche éternelle: simplifier le monde perçu en l'inscrivant dans une répertoire fini.

Quant à la seconde partie de la question, celle qui touche à l’équivalence, Chazal, dans son récent essai (1997), propose de la résoudre par une théorie de la résonance. Pour lui toute forme est nécessairement associée à une matière, dont elle ne peut être séparée que par la pensée. En outre « toute forme possède un pouvoir causal » de sorte qu'il peut se produire une « mise en résonance des structures neurologiques et des formes des objets dans la perception ». Par cette formulation Chazal tente de donner un contenu au concept de prégnance invoqué par René Thom, auteur sur lequel il s'appuie pour admettre l'existence objective des formes (qui sont supposées "dans" les objets4). Dans un tel cadre il va sans dire qu'il n'est plus question de tâtonnements: la concordance, l'équivalence, est d'emblée et de droit parfaite.

Cette conception fait penser à la réplication génétique et à la théorie du même, deux théories qui décrivent, l’une la reproduction automatique des génomes, l’autre la tendance des idées, des systèmes de pensée etc. à se transmettre tels quels dans un groupe d’individus en contact. On aurait ici deux exemples de formes possédant un véritable pouvoir causal. Mais on remarquera aussitôt que le premier fonctionne au plan physique et le second au plan mental : le problème du passage d’une sphère à l'autre demeure entier car on ne voit toujours pas comment donner un contenu précis à ce pouvoir causal que posséderaient les formes, de sorte que la théorie de la résonance reste, dans l’état actuel des connaissances, une solution verbale.

Neurophysiologie et sémiotique: une porte d’entrée et de sortie

On ne peut qu’adhérer à la méthodologie soigneuse qui a permis à Piaget et à ses collaborateurs de mener tant d’expériences judicieuses et de les interpréter avec rigueur. Je pense néanmoins qu’ici également, comme pour Kant, il y a lieu de compléter le tableau dressé par la psychologie génétique à l’aide de découvertes faites depuis lors et qui montrent que le système perceptif introduit déjà une structuration des sensations brutes, à laquelle il n'est pas possible d’échapper, et ce en amont de toutes les actions et opérations qui pour Piaget forment le noyau unique de l’élaboration intellective.

Je voudrais à mon tour proposer quelques réflexions, inspirées de la sémiotique et de la physiologie de la vision, qui pourraient indiquer une voie pour mieux comprendre cette notion de schème, identifier son origine et déterminer sa valeur.

La neurophysiologie, en particulier celle de l’audition et surtout celle de la vision, nous a aujourd’hui appris que le cerveau périphérique transforme déjà le signal sensoriel. Il le contracte et le recode, et il construit au passage des phénomènes perceptifs aussi importants que la ligne, le continu, ou l’égalisation. A leur tour ces trois phénomènes se combinent et forment l’origine de la segmentation ou discrétisation du monde perçu lequel, loin de nous apparaître comme une mosaïque incoordonnée, se présente comme une collection de segments possédant une unité interne et insérés dans un ensemble lui aussi structuré et lié. La psychologie de la forme a été confirmée sur ces points.

Impossible de nier que ces structures nerveuses sont innées. Mais il ne s’ensuit pas que leur origine soit obscure, encore moins qu’elles soient mises à notre disposition avec bienveillance par un être supérieur. On avance parfois aussi qu'elles découlent inévitablement de la consubstantialité de l’homme et du monde qui l’entoure. Les circuits nerveux précâblés sont le résultat de l'évolution, donc d'une pression de sélection qui entérine (ou condamne) leur plus (ou moins) grande valeur de survie. On peut donc les considérer comme une mémoire figée chimiquement, comme le résultat d'un « apprentissage » millénaire et impitoyable. Le processus d’apprentissage individuel est ensuite livré à des facteurs plus rapides, qu’avait évidemment relevé Piaget, tels la transmission éducative et culturelle ou les équilibrages sociaux.

Selon notre conception actuelle, nous n'avons certes pas la preuve que ces structures mentales,- dont l’acquisition permet l'accroissement des connaissances,- sont exactement celles du monde extérieur, mais nous avons une présomption forte qu'elles s’en approchent suffisamment pour assurer la survie de notre espèce. Elles doivent agir dans l'intérêt de l’humain. Pour avoir une valeur de survie elles ne peuvent être en contradiction avec le monde extérieur,... mais il s’agit de la survie de l’homme et non de la mouche ou de la grenouille : le processus est en ce sens biaisé, « intéressé ». De plus le système doit répondre à des cas fréquents, généraux, et ne peut donc être universel : c’est ce que prouvent les cas d'échec du modèle, champ privilégié pour le travail des artistes. Enfin les structures innées en question sont acquises par mutation-sélection. C’est grâce à la mutation aléatoire qu’on peut se passer d'un modèle qui anticipe explicitement les modifications du milieu et faire l’économie de la notion de téléologie. Pour cette raison le modèle est toujours un peu « en retard » sur celles-ci, ce qui l’amène à produire à l’occasion des espèces non encore capables de répondre adéquatement à un environnement changé, soit des espèces ayant conservé des adaptations périmées devenues sans objet.

Les deux savoirs

Avant d’entrer dans le détail d’une analyse des relations entre vision et cognition il me paraît utile de proposer une distinction entre deux types de savoirs. On qualifie communément de savoir, en effet, deux objets mentaux totalement distincts. Le premier est le savoir du botaniste, de l’entomologiste, de tous ceux qui peuvent classer de façon cohérente les objets du monde. Il implique la faculté de distinguer les objets et de concevoir pour cela des critères de plus en plus fins. Je l’appellerai savoir catégoriel. Nous le connaissons sous la forme de Flores, de clés d’identification, d'organigrammes de tous genres. L’ambition de Bacon était de dresser un catalogue, un inventaire aussi complet que possible, des objets du monde, et Linné a rendu ce catalogue rationnel pour tous les êtres vivants. Mais il est un autre type de savoir, qui se base sur les entités observées et décrites par le premier, et qui s'attache à formuler les relations, les liaisons de toutes sortes, quantitatives ou non, qui les unissent. Je l’appellerai savoir algorithmique. Il s’exprime par des équations, par des théories, par des modèles. C’est certainement dans l’élaboration du savoir catégoriel que la perception joue le rôle le plus net. Assez curieusement les professionnels du second considèrent souvent avec condescendance, sinon mépris, les artisans du premier. Il est clair pourtant que le second ne peut exister sans le premier, et que celui-ci est inutile sans l’autre.

La connaissance visuelle élémentaire

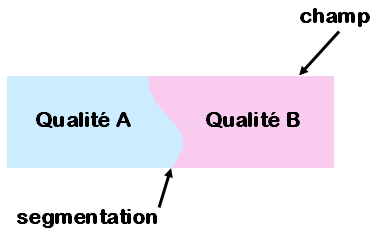

Nous avons décrit ailleurs (Edeline, 1991) ce que nous avons appelé une « connaissance visuelle élémentaire» (CVE), c.à.d. la possibilité de distinguer dans un champ deux qualités translocales différentes, et entre lesquelles existe une discontinuité (fig.1). La discontinuité,- que dans un autre vocabulaire on n’hésite pas à qualifier de catastrophe,- segmente le champ en deux entités, et présente elle-même une forme. Le jeu de la perception est tel que cette forme n’est pas considérée comme ayant une existence indépendante, mais est attribuée soit à une des entités, soit à l’autre, soit encore aux deux. La forme, au sens où nous l’entendons, n’a pas d’étendue.

Fig.1 - Une entité définie par une qualité = une connaissance (visuelle) élémentaire

Il importe de souligner que les deux entités apparaissent en même temps que la relation qui les unit. En fait on peut même affirmer que ces deux entités sont définies par leur relation, laquelle est toujours une forme d’opposition. Et réciproquement la relation ne peut être pensée que portant sur des entités, qui servent ainsi à la définir. On assiste donc à la naissance simultanée d’un savoir catégoriel et d’un savoir algorithmique. C'est du savoir catégoriel qu’il s’agira dans la suite de cet essai.

- Note de bas de page 5 :

-

La catégorisation est une opération de type Σ (cf. Groupe µ, 1970), qui n’a rien de commun avec la décomposition d’un objet en ses parties.

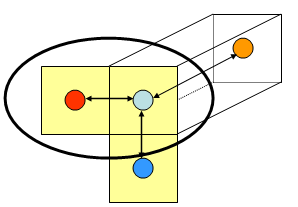

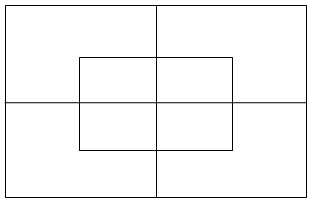

Comment catégoriser5

L’opération unitaire de la catégorisation consiste à partager les entités du monde en deux ensembles selon une propriété distinctive : c’est la catégorisation juxtapositive. Cette opération peut se répéter indéfiniment, chaque nouveau critère introduisant une nouvelle dichotomie (fig.2a), impliquant chaque fois la totalité des objets du monde. Ce type de classement ne peut se représenter qu’en plusieurs dimensions : en principe une par critère. La représentation de Carroll, en deux dimensions, permet de prendre en charge un maximum de trois critères (fig.2b). Au-delà il faudrait passer au cube, à l’hypercube etc. L’important est de souligner que chaque dichotomie porte sur tous les objets du monde et que chaque objet aura été caractérisé par tous les critères distinctifs. L’ordre dans lequel on fait intervenir les critères est indifférent. Toutes les entités sont au même niveau d’analyse. Pour situer une entité dans ce système il faudra une formule de n signes (n = nombre de critères envisagés) affectés d'un + ou d'un – selon que l’entité satisfait ou non à tel critère, p.ex.

A+ B- C+ D+

Fig.2a - catégorisation par juxtaposition (la cellule de base est entourée)

Fig.2b - catégorisation juxtapositive (3 critères maximum en 2 dimensions)

- Note de bas de page 6 :

-

Il a aussi été utilisé par le Collège de 'Pataphysique pour classer les gidouilles selon dix critères (1976).

- Note de bas de page 7 :

-

Malgré les apparences. La faculté de voler a bien été acquise par les insectes, par les oiseaux, par les poissons et par les mammifères, mais c'est par des mécanismes entièrement différents et à l'issue de processus évolutifs étrangers les uns aux autres. Il en va de même pour la vision.

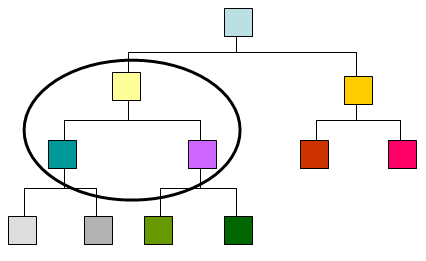

Le principe par juxtaposition est le plus simple imaginable. Il s’est donc facilement généralisé dans le système des index et des mots-clés6. Il ne nécessite aucune mémorisation et les critères utilisés n’ont entre eux aucune relation. Mais de ce fait il ne réduit guère la complexité du monde sensible. C’est une des raisons pour lesquelles on lui préfère à cette fin une catégorisation hiérarchique (fig.3). La cellule de base de la CVE comporte un champ englobant partagé en deux parties complémentaires. On y trouve donc la relation de coordination (entre les parties) et la relation de subordination (entre chaque partie et le tout). Pour obtenir une catégorisation hiérarchique il suffit d’adopter une propriété supplémentaire : l’itération des inclusions. La cellule de base est ainsi répétée indéfiniment, en subdivisant à l’infini les parties. Par ce système les parties ne sont jamais en intersection, alors qu’elles le sont toutes dans le modèle par juxtaposition. Par contre si dans le modèle juxtapositif aucune classe n'en englobe aucune autre, dans le modèle inclusif c’est la règle. Le résultat est une pyramide, une arborescence, facile à représenter en deux dimensions, où chaque branche a son individualité. Les critères intervenant dans la branche A peuvent être différents, et/ou apparaître dans un ordre différent, dans la branche B. Ils peuvent même ne pas s’y présenter, de sorte que toutes les entités ne sont pas nécessairement au même niveau d'analyse. Dans ce modèle les branches, une fois séparées, ne peuvent plus se rejoindre7.

Fig.3 - catégorisation hiérarchique (Arbre de Porphyre)

- Note de bas de page 8 :

-

Où, comme le rappelait Borgès, Dieu occupe la position 231.

On aura reconnu la structure familière des Systématiques en biologie, de la CDU en usage dans nos bibliothèques8, des écrans de distributeurs de billets de banque... Cette fois la complexité est réduite et le champ s'amenuise à mesure qu'on progresse dans les classements. L’effectif des classes diminue à mesure qu’augmente de nombre des critères nécessaires pour les définir. A la limite on ne trouve plus que des individus, alors qu’en tête de classement se trouvent tous les objets du monde. Ceci n’est rien d’autre que le modèle aristotélicien extension/compréhension, dont procède également l’Arbre de Porphyre.

- Note de bas de page 9 :

-

Ceci est illustré plaisamment par les devinettes du genre : Qu’est-ce qui a des dents et qui ne peut pas manger ?

On notera également que le modèle par juxtaposition, n’ayant que deux niveaux, ne peut être le siège que d'une rhétorique très rudimentaire : elle ne pourrait comporter que l’oxymore et une synecdoque généralisante unique. Au contraire le modèle hiérarchique permet toujours, en le remontant suffisamment haut, de trouver un caractère commun à deux entités quelconques, c’est-à-dire de fonder une métaphore. Mais le plus souvent les arborescences que nous construisons, ou auxquelles nous adhérons implicitement, ne sont pas cohérentes : elles passent continuellement du type hiérarchique au type juxtapositif et inversement9.

Innocence de la hiérarchie ?

L’introduction d’une structure « hiérarchisée » n'est pas sans conséquences, de même que n’est pas innocent le terme de « subordination » qui l’accompagne. Faisons, pour une fois, de l’étymologie : hiérarchie vient de ίερος = sacré et de άρχια = commandement...

Parmi l’implicite dissimulé dans le modèle hiérarchique je soulignerai:

- Note de bas de page 10 :

-

« La hiérarchie de la nature est connaissable et est effectivement représentée par un diagramme à embranchements », Cladistic theory, 1992.

-

Une visée totalisante : tout est lié, et si je maîtrise la pyramide entière (même par la pensée seulement) je m’égale à Dieu. L’axiome de Scotland10 exprime cela d’une autre façon.

-

Une prise sur les choses : analysées selon leurs caractères, les choses deviennent manipulables, la hiérarchie pouvant être parcourue de haut en bas aussi bien que de bas en haut.

-

Une dissolution de l'angoisse est amenée par la réduction de complexité et l'augmentation d'intelligibilité.

Une autre caractéristique du modèle inclusif, non généralement relevée, c’est que l’ordre d’application des critères distinctifs y est essentiel (contrairement au modèle juxtapositif), de sorte qu’une dimension temporelle s’y greffe aisément. La classification linnéenne représentait, pour son auteur, le plan même adopté par la divinité pour sa création. Cette classification est devenue, avec le progrès de la science, phylogénétique. Elle dépeint désormais non seulement les espèces mais l'évolution des espèces. Or en toute rigueur le modèle hiérarchique est intemporel : il faudrait donc introduire ici un troisième modèle : « catégoriel hiérarchique génétique ».

Perspectives

Le titre « Voir et Savoir » n’est qu’une paronomase commode. Le chemin est long qui mène de l’un à l’autre. Les termes connaissance et savoir ne sont pas synonymes, et il faudrait déterminer où et comment advient cette plus-value mentale qui fait d’une connaissance un savoir. En d’autres termes c’est la question du sens tout entière qui reste à résoudre. Des suggestions intéressantes ont été faites à ce propos par l’école danoise de Biosémiotique (voir par exemple Hoffmeyer et Emmeche, 1991). Pour l’instant nous en sommes toujours réduits à des spéculations. Mais ce qui paraît à portée plus immédiate, c’est de clarifier ce qui se passe au fond de la rétine, là où des faisceaux de rayons lumineux sont codés en trains d’impulsions électriques (Edeline, 2008).